Как алгоритмы Яндекса и Google определяют контент, написанный нейросетями

Нейросети постепенно избавляют работодателей от необходимости платить зарплату сотрудникам, хотя еще пару лет назад почти никто не верил, что такое вообще возможно (я тоже). Да и сейчас сложно смириться с тем, что текст для сайта или статью часто пишет ИИ. Однако сильно переживать пока не стоит, поскольку искусственный интеллект не может полностью заменить человека. И поисковые роботы тоже это понимают и умеют отличить текст, написанный роботом и человеком. Яндекс и Google очень любят свои алгоритмы, и в марте этого года они их обновили в очередной раз – речь о тех, которые определяют, качественный перед нами контент или нет. Санкции, как обычно, неприятные: генерируете текст нейросеткой – получаете просадку по позициям, а в каких-то случаях поисковики злятся сильнее, и сайт не индексируется.

Ситуация такова: тренд на использование нейросетей в продвижении в интернете, но и санкции от ПС, которые стали еще жестче, никуда не девались. И что делать – отказываться от применения ИИ в текстах совсем или генерировать контент, чтобы потом надеяться, что робот Яндекса или Гугла не заметит?

(робот заметит)

Вот в этом вопросе и попробуем разобраться – ситуация неоднозначная, отказываться от AI – как-то странно, учитывая, что используют нейросети если не все, то многие; но и полагаться только на искусственный интеллект рискованно. Давайте обсудим, как создавать контент, чтобы не попасть под фильтры от ПС и как применять ИИ при написании текстов.

Апдейты 2024 от Google, которые борются с некачественным контентом: Spam Update и Core Update

Намерения у компании серьезные – по заявлениям специалистов Google, они планируют сократить количество низкокачественного контента аж на 40%. Сначала Гугл запустил обновление Core Update – своего алгоритмического ядра. Цель заключается в том, чтобы показывать в выдаче пользователю только наиболее полезную информацию, релевантную его запросам, а неуникальные и некачественные материалы – соответственно, не показывать. Гугл здесь снова неизменно следует принципам E-E-A-T (опыт, экспертность, авторитетность, достоверность), согласно которым тексты должны писаться экспертами в своей сфере, имеющими в ней опыт, чтобы получившийся материал был полезен для читающего и не вводил в заблуждение.

Ну а сайты, на которых размещен контент, сгенерированный ИИ (что полностью созданный AI, что рерайты, сделанные нейросетями), будут понижаться в выдаче.

Обновление Spam Update нацелено на борьбу со спамом (удивительно, да?) и «вредными» сайтами. Нарушения, за которые Гугл будет выписывать санкции сайтам, следующие:

|

|

Контент низкого качества в больших количествах. Например, создание страниц, на которых размещены тексты под конкретные запросы. Тексты, само собой, обычно используются неуникальные и однотипные – часто их и делают при помощи нейросетей.

|

|

|

Использование для других целей домена, у которого истек срок регистрации. Поясним: у вас был сайт, посвященный психологическому центру, а затем его начали юзать как платформу для рекламы или продажи товаров, продвижения чего-то незаконного или законного, но чего-то нетематического. Что ж, получайте санкции.

|

|

|

Размещение текстов, не соответствующих направлению сайта. Сайт и бизнес связаны неразрывно – к примеру, у вас компания, занимающаяся арендой спецтехники, но вдруг вы начали писать в блоге тексты про то, как выбрать бытовую химию. Роботы Гугла подумают, что вы злоупотребляете репутацией сайта, чтобы получить внешние ссылки. |

Как Яндекс обновил свои алгоритмы в 2024 году: чего бояться в этот раз

У Яндекса тоже есть алгоритм, который понимает, что контент плохого качества или написан нейросетью – его также обновили. Во главе всего – польза для читателя, поэтому поисковая система с помощью специальной метрики отслеживает соответствие контента запросу пользователя и определяет ценность текста для него.

Требования учитываются при ранжировании страниц в поисковой выдаче – во главе угла характерные для Яндекса полезность для пользователя, экспертность и доверие читателя. Имейте в виду, что оптимизацию никто не отменял, она так же, как и всегда, важна для продвижения сайта, но, о чем мы постоянно говорим, на первом месте по-прежнему польза для читателя. Иными словами – когда будете писать текст, держите в голове мысль, что вы создаете его для людей, а не поисковых роботов.

За что Яндекс будет банить в 2024:

-

сгенерированный или скопированный откуда-то контент – не так важно, написали ли вы текст нейросетью или просто «утащили» откуда-то, итог один – получите санкции;

-

вода – если в текстах много того, что можно без потерь удалить, как раз та самая вода, то поисковый робот это заметит и погрозит пальчиком,

-

сомнительная польза для читателя – контент не дает ответов на запрос пользователя, в нем нет ценности,

-

недостоверные материалы – не указано авторство, контент создан тем, кто не является экспертом в данной области или без его помощи, не использовались авторитетные источники.

Кроме того, после апдейта алгоритм Яндекса куда более внимательно проверяет контент в областях, которые посвящены здоровью и безопасности пользователей: все, что касается финансовых вопросов, юриспруденции, медицины и т. д. Тексты, написанные в рамках таких тематик, обязательно должны проверяться экспертами или создаваться ими, чтобы не обмануть или не повлиять негативно на читателя.

Чем плох контент, созданный с помощью нейросетей, и почему с ним борются поисковики

Кто-то считает, что текст можно написать, используя искусственный интеллект – ИИ отлично справляется с кучей различных операций, значит, и тут проблем не будет. На самом деле, будет.

Неспроста и Яндекс, и Google стараются научить своих поисковых роботов распознавать сгенерированный контент. Почему так происходит – что AI умеет практически все, но не написать хороший текст? Да все очень просто – нейросети, в отличие от человека, неживые: транслировать эмоции, быть эмпатичными они не могут. Да, мы сейчас говорим о продающем и информационном контенте, который несет исключительно пользу и выгоду, однако собственный стиль, определенный слог и манеру передачи информации роботы не имеют. Нейросеть при генерации текста использует уже то, что есть в интернете, и свои собственные алгоритмы, основанные на опыте человека – с нуля что-то, что обладает добавочной ценностью, создать им не под силу. Пока что.

Если проще, ИИ собирает что-то условно новое, но из того, что уже есть в сети. Это отлично поможет, когда человек уже устал, запутался, попал в тупик и т. д. Например, нужно быстро накидать план, а идей нет – ИИ гораздо быстрее набросает идеи, однако результат потребует корректировки живым организмом.

Поисковые системы опираются на принципы E-E-A-T – это правильно со всех точек зрения. Информация должна быть достоверной, а нейросеть может написать текст с недостоверными и даже опасными в каких-то аспектах сведениями. Если раньше баны раздавались за откровенно некачественный контент – спам, копипаст, просто воду и прочий мусор, то сейчас ПС уже в состоянии отличить контент, сгенерированный нейросетью. А как они это делают? Сейчас обсудим.

Качество – не количество: как Яндекс и Google борются с некачественным контентом в эпоху AI

В Яндексе однозначных заявлений не делали, но очевидно, что сайты с плохими текстами будут понижаться в выдаче, а порталы с полезными и реально хорошими материалами – подниматься. Что конкретно будут делать поисковые роботы – не сказали, но понятно, что санкции выдадут.

Google, как и до этого, будет жестко наказывать за спам – вплоть до деиндексации. Originality.ai провели расследование исследование и выяснили, что уже выдали подарок в виде штрафных санкций 1 146 сайтам. На всех был контент, созданный нейросетями. Причем почти на половине этих порталов количество таких материалов превышало 90%!

Также в сети гуляет информация, что из выдачи улетели страницы, на которых рассказывали, как генерировать тексты нейросетями без вреда для сайта. Ну дорассказывались, получается, просчитались.

Что делать, чтобы вас забанил поисковик не попасть под санкции поисковых систем. Нельзя:

|

|

публиковаться на просроченных доменах и нетематических площадках – важно не количество ссылок, но и их качество, |

|

|

размещать нетематический и нерелевантный контент: не нужно писать про то, как выбрать садовый опрыскиватель на сайте фотостудии, |

|

|

намеренно писать некачественные тексты, чтобы подниматься в выдаче – сделаете так, будет только хуже. |

Можно ли использовать нейросети при написании текстов – непонятно, вопрос до сих пор актуален.

Парадокс нейросетей: зачем они нужны, если поисковики против

Странно – Яндекс создал свою нейросеть, напичкал собственный браузер кучей ИИ-фишек, но при этом формально против контента, который генерирует искусственный интеллект.

Ответ прост – инструменты, которые компания разрабатывает, направлены на то, чтобы сделать серфинг в интернете удобнее и лучше для пользователя: перевод и пересказ страниц, видео, нейропоиск и прочие призваны облегчить поиск информации, оптимизировать работу. А тексты, которые пишет AI, пока что несовершенны, многое зависит от тематики, того, какой промт для их создания прописан и других факторов. Одним словом, однозначно полагаться на искусственный интеллект в этом аспекте нельзя.

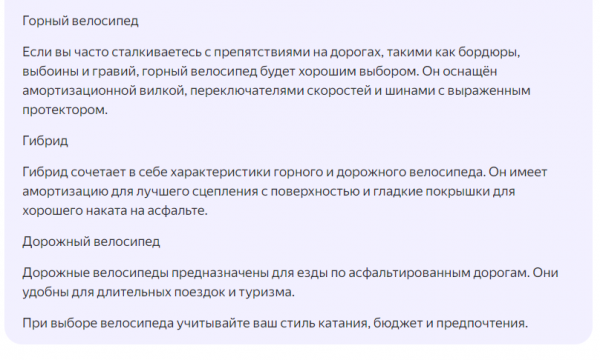

Разберем на примере. Представим, что мы с вами не едем в отпуск летом, а просто сидеть дома не хочется, поэтому решаем выбрать велосипед, чтобы кататься в городе по вечерам после работы. Обратимся к YandexGPT:

Получаем довольно общий и водянистый текст о типах велосипедов – это достаточно общая информация, ценности статья не несет, как минимум, потому что не отвечает на главный вопрос. Ни слова про материалы рам и размеры, количество скоростей (и вообще необходимость в их большом количестве), вес и прочие важные характеристики. Это в целом довольно сложная тема со множеством нюансов, так что далеко не каждый человек может дать внятный ответ. Однако разница как раз в том, что у людей есть личный опыт, который можно описать в статье.

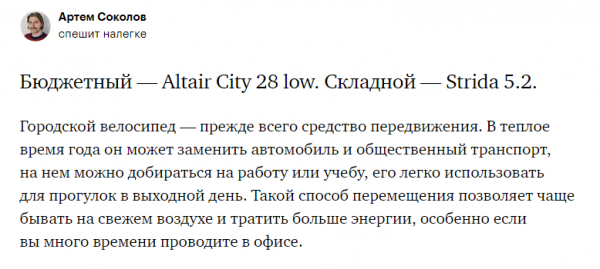

К примеру, вот фрагмент текста из ТЖ по тому же запросу:

Обратите внимание на вводный абзац – он уже гораздо лучше, чем вариант от нейросети, поскольку описывает конкретные ипостаси использования городского велосипеда. Заметьте, городского – не велосипеда в целом, они бывают разными. Сразу сокращается дистанция между читателем и автором – к тому, кто написал статью, уже больше доверия.

Более того, автор прямо пишет, что консультировался с экспертом. Шульц – компания, которая создает велосипеды для города и путешествий, соответственно, люди что-то да понимают. Также автор сразу дает ссылку на товар и указывает цену, вы прямо из статьи можете перейти и заказать велосипед себе или узнать адрес офлайн-магазина и съездить посмотреть интересующий лот туда (если что, то очень советую именно так и делать).

Статья не грузит обывателя кучей подробностей и не советует купить кантрийник на Shimano XTR и Rock Shox SID (если вы сейчас не поняли, что это, то значит, в статье на ТЖ автор все сделал верно) или собрать кастом на запчастях с Алиэкспресс. Нет ничего ненужного, все просто и доступно, как и должно быть.

Текст отлично попадает в аудиторию – это люди, знающие о велосипедах не так много. А те, кто разбирается в этом, и без всяких статей знают, что им выбрать.

Иными словами, искусственный интеллект пока не способен понимать нас так же, как и мы сами. Глобально проблема, конечно, не в этом. Точнее, не только в этом, но тем не менее – она есть.

А что человек?

Да, робот уже может написать картину и симфонию сочинить, но не лучше, чем люди. Но будто мы с вами не писали никогда плохих текстов? Пфф. В основном роботы и собирают информацию из сети, которую туда загрузил кто? Верно – человек. Множество текстов, написанных людьми, плохие – они не несут пользы, они неуникальны, в них нет добавочной ценности, пользы. ИИ в состоянии создать контент лучше, чем огромное количество людей. Именно по этой причине тексты пишут специально обученные специалисты.

Поисковик борется не с нейросетями, а с писаниной, не несущей пользы – вовсе не важно, кто автор: условный Василий или робот. Здесь речь о том, что нейросети – это инструмент для помощи в решении определенных задач, а не волшебная палочка, которой можно спихнуть свои задачи и пить чай весь день. ИИ нужно уметь пользоваться: просто попросить написать текст за вас не получится.

Что делать в итоге? Да все просто. Писать тексты самим, тщательно изучать свою целевую аудиторию – вы же делаете это для людей, учитывайте, что важно тому, кто ищет информацию по определенному запросу, сообщайте только проверенные данные, опирайтесь на авторитетные источники или консультируйтесь с экспертами. Нейросети использовать можно, но в качестве помощника, который подскажет что-то, накидает идей, быстро найдет нужную информацию. Это инструмент, а не ваш личный сотрудник, с радостью сделающий вообще все.

Природный камуфляж, или как отличить текст, написанный нейросетью

Тигр не просто так полосатый, леопард (в тренде) пятнистый, а змея узорчатая – это все нужно для маскировки. Чтобы заметить кого-то из них, надо постараться, а чтобы увидеть, что контент создан роботом, потребуются глаза и мозг некоторые усилия.

Искусственный интеллект не пишет, а генерирует. В этом основное отличие – ничего принципиально нового ИИ не создаст, он соберет информацию по сети и как-то соединит ее в более-менее связный текст, даже уникальный технически, но не по смыслу. Отличить такой контент от человеческого легко, особенно если вы уже удручены копирайтерским или редакторским опытом.

-

Одно по одному. ИИ пишет чересчур вылизанно: всегда правильный порядок слов, как по учебнику. Иногда напоминает учебники по русскому языку для иностранцев, составленные самими иностранцами, а не носителями этого языка. Иван, ты будешь пить водку? Да, Наталья, я буду пить водку. Люди так не разговаривают. Конструкции похожи и однотипны, разнообразия нет.

-

Шаблоны. Нейросеть не проходила курсы по копирайтингу за две недели и вряд ли знает, что здороваться на главной сайта не надо, использовать клише не стоит – и т. д. Все, что мы с вами избегаем, ИИ нет-нет да сделает. Обращайте внимание на это, но имейте в виду, что живые люди тоже таким страдают, поэтому важно смотреть и на прочие факторы.

-

Фактические ошибки. Всем свойственно косячить, но нейросети делают это по-своему, не так, как мы. Вспомните эти руки, где по 7 пальцев на картинках, которые нарисовал ИИ – здесь похожая ситуация: иногда есть, иногда нет. Если попросить нейросеть написать какой-то сложный текст, то можно увидеть фактические неточности. Часто это проявляется в статистических данных или чем-то подобном. Проверяйте информацию, которую для вас собрала нейросеть.

-

Небогатая речь. ИИ не блещет лексическим разнообразием – повторы и тавтологии в пределах одного высказывания – частая практика. Порой мы и сами это делаем, но у нейросетей стилистические ошибки выглядят по-особому и сразу бросаются в глаза.

-

Беды с логикой. «Сапсан – самая быстрая птица в мире, быстрее сапсана летает только…» – стоп, что? Нейросеть играла с логичностью изложения – и проиграла. Вообще нарушать все законы логики ИИ любит, так как собирает данные из разных источников и не может заметить противоречие в одном предложении.

-

Поверхностные рассуждения. Текста много, но пользы в нем нет – готовьтесь этому, если генерите тексты ИИ. Нейросеть соберет информацию из разных источников, сделает связные предложения, даже структурно правильно их расположит, но вот пользы не добавит. Общие фразы, не несущие смысла, отсутствие экспертизы – вот примерно такой результат вполне вероятен. Спросите, сколько минут варить рис, у нейросети – и она расскажет, где он выращивается, кто начал собирать рис и т. д.

-

Ноль эмоций. Уилл Смит был прав – роботы не умею чувствовать, и это заметно по текстам в том числе. ИИ сгенерирует максимально сухой и пресный текст – и не в том смысле, что это строгость, необходимая в тематике – нет. Все тексты будут такими, даже про котиков, а как можно писать про котиков сухо? Они же такие хорошенькие.

-

Нет личного опыта. А откуда ему у нематериальной сущности вообще быть? ИИ, конечно, может мимикрировать под чей-то описанный ранее опыт и выдать его за свой, но это лишь имитация. Размышлять роботы так, как живой человек, не умеют.

-

Безличность. Она проявляется в конструкциях по типу «что делает», «что позволяет», «что помогает» везде, где только можно (нельзя) – если видите, что текст изобилует подобным, то его либо писал пятиклассник, либо нейросеть. Только задайте вопрос, а пятикласснику нужно было писать про то, как использовать прецизионные гайки?

-

English-конструкции. Если вы знаете, что такое дискета, и даже ей пользовались, то помните Promt, который переводил так, как никто бы никогда не сказал. Многие нейросети созданы не в России и обучались на англоязычных материалах и поэтому иногда нет-нет да похвастаются своим престижным образованием. Например, напихают модальных глаголов в русское предложение, типа быть, иметь, должен и прочее – то есть видно, что текст переведен, причем не очень качественно.

Да, такое может быть и в текстах, которые написали люди, но не в таких масштабах. Неестественность легко увидеть, если человек делает что-то плохо, это выглядит не так. Вопрос лишь в том, что любой материал, написанный роботом или вашим сотрудником надо проверять. Слепо полагаться на что-то не стоит.

Так, а что делать: писать все самим или доверить какую-то работу роботам?

Не знаю, что произойдет, когда будет восстание машин – возможно, их остановит старая добрая, надежная, как автомат Калашникова, щеколда на двери, а робот пылесос запутается в шторах. А если серьезно, то исключать нейросети не стоит: они нам не вредят, просто пока не все умеют, а только учатся. Доверить рутинные задачи, поиск информации, придумывание идей – можно. ИИ обработает большие объемы данных быстрее, чем человек. Главное, потом проверить результат.

Как поисковики будут бороться с контентом, сгенерированным нейросетями, интересно – остается наблюдать за битвой двух роботов. И те, и другие активно обучаются.

А писать тексты стоит так же, как и раньше – для людей, нести лучи добра, пользу, проверять данные и следить за качеством контента. Лучшая стратегия, как сейчас модно говорить, – это экологичное использование нейросетей.

Источник: seonews.ru